Interview

Agentic AI in der Praxis – so entsteht der Companion for First

Projektleiter Norman Janert gibt Einblicke in unser aktuelles KI-Projekt, das Fachlogik, Cloud-Technologie und echte Nutzerbedürfnisse zusammenbringt.

Fact:

Norman, Sie entwickeln seit vielen Jahren Software und verantworten nun auf der technischen Seite die Konzeption und Realisation des Companion for First. Mit welchen Herausforderungen sehen Sie sich derzeit konfrontiert?

Norman Janet:

In der ersten Phase geht es ja vorrangig um Datenauswertung und Visualisierung. Nutzer sollen den Companion for First mit ganz konkreten Fragen zu ihren Beständen konfrontieren können. „Welche Anleihen laufen in den nächsten 12 Monaten aus?“, „Welche Fonds haben in den vergangenen 6 Monaten eine Volatilität von mehr als 10 % gezeigt und gleichzeitig eine positive Performance?“.

Um diese Fragen erst zu verstehen und dann auch konkret zu beantworten, muss der Companion über ein sehr spezifisches Wissen im Hinblick auf die Funktionen, Arbeitsabläufe und letztlich auch die internen Datenstrukturen von First Cloud verfügen. Und über viele relevante Begriffe aus der Finanzwelt selbstverständlich auch. Dass etwa mit dem „Rente“ eher nicht die persönliche Altersversorgung gemeint ist, sondern ein festverzinsliches Wertpapier, muss der Companion automatisch korrekt einordnen können. „Context is king“, wie wir immer sagen.

Fact:

Sicher keine geringe Aufgabe. Wie ist denn Ihr Team aufgestellt?

Norman Janert:

Wir sind knapp ein Dutzend Personen, die schwerpunktmäßig am Companion arbeiten. Unser Team umfasst Software-Entwickler, Data-Scientists und natürlich die Fachexperten, die teils seit vielen Jahren unser Produkt First bzw. First Cloud betreuen. Außerdem haben wir uns mit der Firma Silpion aus Hamburg externes Know-how ins Boot geholt, weil die Kollegen dort über eine gute Anbindung an das universitäre Umfeld verfügen. Bei aktuellen Forschungsthemen sind wir so stets auf dem neuesten Stand.

Fact:

Mittlerweile hat man ja regelmäßig den Eindruck, moderne KI-Systeme wüssten und könnten bereits fast alles. Wäre es da nicht ein Leichtes, einfach Chat-GPT, Google Gemini oder Perplexity AI auf First Cloud loszulassen?

Norman Janert:

Ja, das wäre natürlich schön, aber in der Praxis viel zu kurz gedacht (lacht) – sowohl technisch als auch strategisch und schon gar nicht im Hinblick auf die Praktikabilität.

Fact:

Das müssen Sie uns erklären.

Norman Janert:

Zunächst einmal wollen wir die Interna unserer Produkte natürlich nicht in fremde Hände geben, das ist sicherlich nachvollziehbar. Außerdem haben wir Anforderungen, die selbst die fortschrittlichsten KI-Modelle nach wie vor nicht erfüllen. Also kein Halluzinieren, sprich Erfinden von falschen Fakten, keine unterschiedlichen Antworten bei der Wiederholung von Fragen. Was Ihnen der Companion zurückmeldet, muss immer Hand und Fuß haben und auch in jeder Aussage exakt stimmen – bis auf die letzte Nachkommastelle. Und die strenge Regulatorik, der unsere Kunden etwa durch die BaFin unterworfen sind, will natürlich auch vollumfänglich berücksichtigt sein. Sonst macht das Ganze keinen Sinn.

Fact:

Aber deshalb werden Sie das Rad in Sachen KI doch sicher nicht neu erfinden?

Norman Janert:

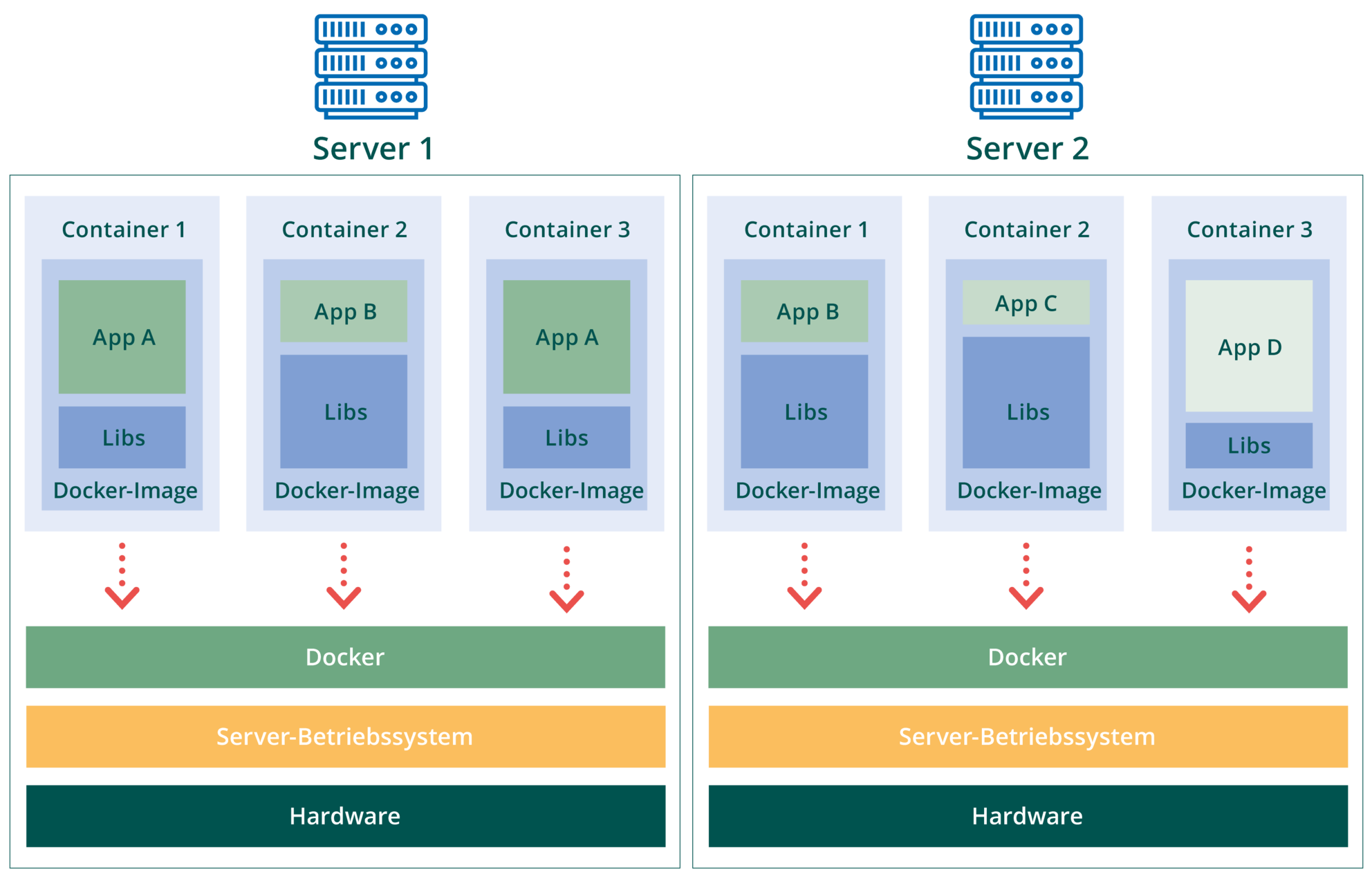

Nein. Wenn man sich die Verarbeitung von Nutzeranfragen durch den Companion aus der Vogelperspektive anschaut, sieht man, dass das Ganze auf einer sogenannten RAG-Pipeline mit sehr kleinteiligen Schritten basiert: Vom „Verstehen“, was der Nutzer möchte, über den Aufbau einer Fragestellung, welche Daten aus First involviert sind, den eigentlichen Datenabruf und die anschließende Umwandlung der Ergebnisse in sprachliche Aussagen oder Grafiken, um es einmal stark vereinfacht darzustellen.

In vielen dieser Prozessschritte sind externe Large Language Models als kognitive Elemente involviert, die berühmten „Arbeitsesel“ der künstlichen Intelligenz. Die müssen wir wirklich nicht neu erfinden und könnten es vermutlich auch gar nicht.

Fact:

Unsere Leser interessiert an dieser Stelle bestimmt, welche Large Language Models Sie präferieren. Schließlich ist das die Arena, in der sich die großen Player des KI-Marktes derzeit ein offenes und spannendes Rennen liefern, in das Milliardensummen investiert werden.

Norman Janert:

Ja, die Entwicklungen in diesem Bereich sind wirklich atemberaubend und hochdynamisch. Und deshalb wollen wir uns diesbezüglich auch nicht festlegen. Wir entwickeln komplett LLM-agnostisch, das heißt, unsere internen Schnittstellen kann man mit wenigen Klicks von einem LLM auf ein anderes umstellen.

Für uns ist immer wieder überraschend, welche Leistung die verschiedenen Modelle bieten, wie es mit der Performance, der Verlässlichkeit, der Sicherheit und natürlich auch mit den Kosten aussieht. Wir haben schon festgestellt, dass für unsere Zwecke gar nicht die jeweils größten und komplexesten Modelle erforderlich sind. Am Ende werden wir uns für das Modell entscheiden, das am besten zu unseren Anforderungen passt.

Fact:

Eröffnet das nicht auch eine Perspektive, auf lokale LLMs zu setzen?

Norman Janert:

Absolut, und das würde uns natürlich noch mehr Kontrolle und auch die Möglichkeit bieten, unsere Modelle vorzutrainieren. Wir wissen aber zum jetzigen Zeitpunkt noch nicht, ob das nötig sein wird. Und ich möchte auch noch einmal betonen: Selbst da, wo wir auf externe LLMs zurückgreifen, können angesichts unserer kleinteiligen Vorgehensweise keine kundenrelevanten Daten abfließen. Diese Daten verbleiben in den internen Prozessschritten, die dazwischen liegen.

Außerdem darf man nicht vergessen: Sobald man kostenpflichtige Business-Leistungen der LLM-Anbieter einsetzt, versichern diese ja auch vertraglich, dass ihre Modelle nicht mit den durchgeschleusten Daten trainiert werden. Man bezahlt also auch ein Stück weit für das sofortige Vergessen.

Fact:

Sie entwickeln eine umfassende KI-Funktionalität für ein bestehendes, bewährtes Produkt. Setzen Sie bei dieser Entwicklung auch selbst auf KI?

Norman Janert:

Durchaus. In der gesamten Produktentwicklung der Fact nimmt die Nutzung von KI-Tools seit etwa zwei Jahren breiten Raum ein. Und das ist ja wirklich ein Feld, wo die KI bereits sehr stark ist und viele ihrer Versprechen eingelöst hat. Ich selbst kodiere nur noch wenig von Hand, sondern mache Ansagen, die die KI in konkreten Programmcode umsetzt. Erst gestern hat ein Kollege zwei wichtige Module per KI „refakturiert“, wie das nachträgliche Umstrukturieren von Programmcode bei uns heißt. Das Ganze dauerte zehn Sekunden. Von Hand hätte er dafür mindestens zwei Arbeitstage benötigt.

Fact:

Wie ist denn der aktuelle Stand der Entwicklung beim Companion for First?

Norman Janert:

Nun, wir haben gezeigt, dass unsere Ansätze funktionieren. An einigen Stellen sogar besser, als anfangs vermutet. Unsere Strategie, weniger auf spezifische Tools, sondern mehr auf Konzepte und Methoden zu setzen, ist voll aufgegangen. Darauf sind wir ein wenig stolz, denn die KI ist ja doch insgesamt ein durchaus komplexes Feld, wo man an vielen Stellen Neuland betritt.

Jetzt sind wir seit einigen Monaten mit der Fleißarbeit beschäftigt: das Wissen über die internen Strukturen integrieren, die Umsetzung der generierten Datenabrufe, das Feintuning beim Prompt-Engineering, das Testen, die Zusammenarbeit mit unserem Pilotkunden. Vor uns liegt also noch ein Stück des Weges, aber wir sind sicher, dass der Companion unseren Kunden einen enormen Mehrwert liefern wird. Das wird schon eine kleine Revolution.

Fact:

Und können Sie bereits absehen, was für Ihr Team danach kommt?

Norman Janert:

Vermutlich erst mal ein paar Tage Urlaub! Die Fertigstellung eines Software-Produkts ist ja doch immer mit einem großen Kraftakt verbunden. Aber tatsächlich haben wir schon die nächsten Entwicklungsstufen des Companions im Blick. Man kann sich etwa vorstellen, dass der Companion KI-gestützt komplexe Analysen durchführt und daraus Reports für das Management und das Controlling generiert. Er könnte selbstständig externe Finanznachrichtenquellen auf wichtige Neuigkeiten zu den Assets im Depot eines Kunden durchsuchen oder beispielsweise regelmäßig im Hintergrund die umfangreichen Logdateien des Systems auswerten und Erklärungen für aufgetretene Anomalien liefern. Damit werden wir uns 2026 und 2027 beschäftigen.

Fact:

Norman, wir danken Ihnen für das Gespräch.